bs4--xlwt存入excel

发布时间:2018-07-03 11:14:11编辑:Run阅读(6106)

在python标准库中,并没有直接操作Excel模块,需要借助第三方模块

xlrd模块负责从Excel中读取数据

xlwt则是将数据写入到Excel中去

这里需要用到xlwt模块,从第三方库中安装xlwt模块很简单,一条命令足以

pip3 install xlwt

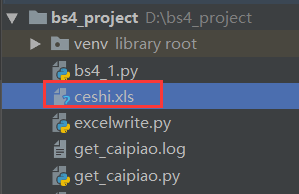

先写一个简单的python程序测试一下,创建一个名为excelwrite.py文件,代码如下:

# 导入xlwt模块

import xlwt

if __name__ == '__main__':

# 创建一个Workbook对象book,

book = xlwt.Workbook(encoding='utf8', style_compression=0)

# 创建一个sheet对象,并添加表名为dede

# 一个excel可以有多个表,每个表都有对应的表名

sheet = book.add_sheet('dede')

# 向dede表中添加数据

sheet.write(0, 0, 'hstking') # 0行0列写入hstking

sheet.write(1, 0, '中文测试') # 1行0列写入中文测试

sheet.write(1, 1, 'ceshi') # 1行1列写入ceshi

# 将以上操作保存到指定的Excel文件中

book.save('ceshi.xls') # 里面写的是路径,不写代表当前目录下运行程序:

会在当前目录下生成一个名为ceshi.xls的文件

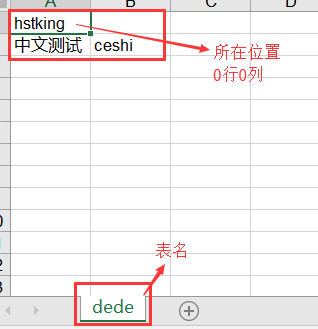

打开Excel文件内容如下:

在之前双色球项目的同目录下创建一个save2excel.py文件,用来把数据存入excel文件的,内容如下:

#!/usr/bin/env python

# coding: utf-8

import xlwt

class SaveExcel(object):

def __init__(self, items):

self.items = items

self.run(self.items)

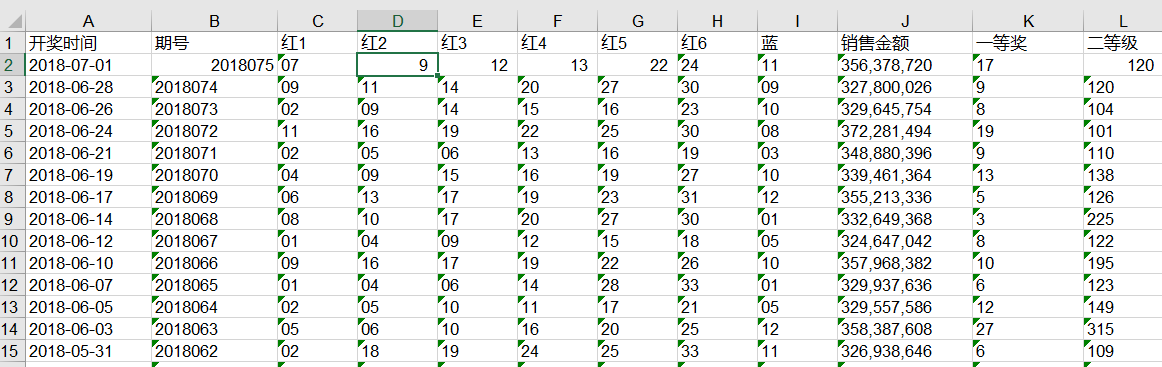

def run(self, items):

filename = '双色球.xls'

book = xlwt.Workbook(encoding='utf8', style_compression=0)

# cell_overwrite_ok,表示是否可以覆盖单元格

sheet = book.add_sheet('ball', cell_overwrite_ok=True)

sheet.write(0, 0, '开奖时间')

sheet.write(0, 1, '期号')

sheet.write(0, 2, '红1')

sheet.write(0, 3, '红2')

sheet.write(0, 4, '红3')

sheet.write(0, 5, '红4')

sheet.write(0, 6, '红5')

sheet.write(0, 7, '红6')

sheet.write(0, 8, '蓝')

sheet.write(0, 9, '销售金额')

sheet.write(0, 10, '一等奖')

sheet.write(0, 11, '二等级')

i = 1

while i <= len(items):

item = items[i-1]

sheet.write(i, 0, item.lottery_date)

sheet.write(i, 1, item.lssue)

sheet.write(i, 2, item.red1)

sheet.write(i, 3, item.red2)

sheet.write(i, 4, item.red3)

sheet.write(i, 5, item.red4)

sheet.write(i, 6, item.red5)

sheet.write(i, 7, item.red6)

sheet.write(i, 8, item.blue)

sheet.write(i, 9, item.money)

sheet.write(i, 10, item.firstprize)

sheet.write(i, 11, item.secondprize)

i += 1

book.save(filename)

if __name__ == '__main__':

pass更改之前的get_caipiao.py文件,加上excel存储

#!/usr/bin/env python

# coding: utf-8

from bs4 import BeautifulSoup

import urllib.request

from mylog import MyLog as mylog

from save2excel import SaveExcel

import re

import time

class CaiPiaoItem(object):

lottery_date = None # 开奖日期

lssue = None # 期号

red1 = None # 第一个红色球号码

red2 = None # 第二个红色球号码

red3 = None # 第三个红色球号码

red4 = None # 第四个红色球号码

red5 = None # 第五个红色球号码

red6 = None # 第六个红色球号码

blue = None # 蓝色球号码

money = None # 销售额

firstprize = None # 一等奖人数

secondprize = None # 二等奖人数

class GetCaiPiao(object):

def __init__(self):

self.urls = []

self.filename = '双色球.txt'

self.log = mylog()

self.geturls()

self.items = self.spider(self.urls)

self.pipelines(self.items)

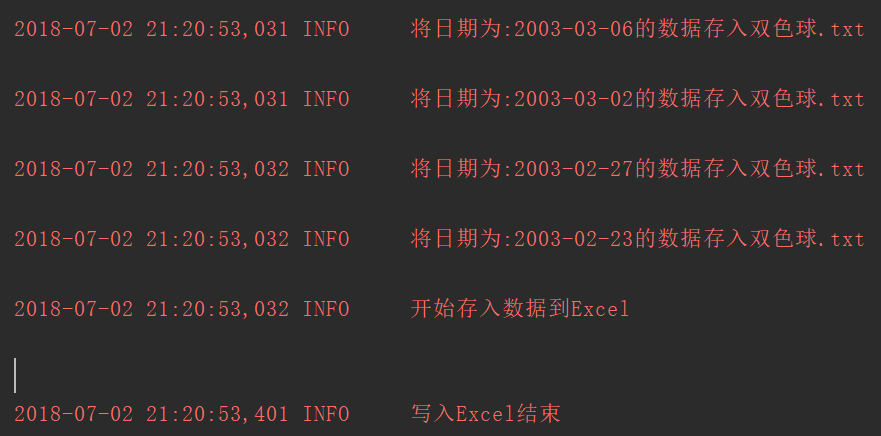

self.log.info('开始存入数据到Excel\r\n')

SaveExcel(self.items)

self.log.info('写入Excel结束\r\n')

def geturls(self):

# 初始url地址

url = 'http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html'

htmlcontent = self.getresponsecontent(url)

soup = BeautifulSoup(htmlcontent, 'lxml')

# 获取最后一个p标签

tag = soup.find_all(re.compile('p'))[-1]

# 取出总页数---115

pages = tag.strong.get_text()

for i in range(1, int(pages)+1):

# 拼接每一页的url地址

url = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list_' + str(i) + '.html'

self.urls.append(url) # 把每个url地址添加到urls列表

self.log.info(u'添加URL:{}到URLS\r\n'.format(url)) # 记录日志

with open(self.filename, 'w', encoding='utf-8') as f:

f.write("开奖日期 期号\t红1 红2 红3 红4 红5 红6 蓝7\t销售额\t1等奖人数\t二等奖人数\n")

def spider(self, urls):

items = []

for url in urls:

htmlcontent = self.getresponsecontent(url)

soup = BeautifulSoup(htmlcontent, 'lxml')

tags = soup.find_all('tr', attrs={})

for tag in tags:

if tag.find('em'):

item = CaiPiaoItem() # 实例化CaiPiaoItem类

tagtd = tag.find_all('td')

item.lottery_date = tagtd[0].get_text() # 获取开奖日期

item.lssue = tagtd[1].get_text() # 期号

itemEM = tagtd[2].find_all('em') # 获取所有的em标签

item.red1 = itemEM[0].get_text() # 获取第一个红球的号码

item.red2 = itemEM[1].get_text() # 获取第二个红球的号码

item.red3 = itemEM[2].get_text() # 获取第三个红球的号码

item.red4 = itemEM[3].get_text() # 获取第四个红球的号码

item.red5 = itemEM[4].get_text() # 获取第五个红球的号码

item.red6 = itemEM[5].get_text() # 获取第六个红球的号码

item.blue = itemEM[6].get_text() # 获取蓝球的号码

item.money = tagtd[3].find('strong').get_text() # 获取销售额

item.firstprize = tagtd[4].find('strong').get_text() # 获取一等奖中奖人数

item.secondprize = tagtd[5].find('strong').get_text() # 获取二等奖中奖人数

items.append(item) # 把item对象添加到items列表

self.log.info(u'获取日期为:{}的数据成功'.format(item.lottery_date)) # 记录日志

return items # 返回items列表

def pipelines(self, items):

with open(self.filename, 'a', encoding='utf-8') as f:

for item in items:

f.write('{} {}\t{} {} {} {} {} {} {}\t{}\t{}\t{}\n'.\

format(item.lottery_date, item.lssue, item.red1, item.red2, item.red3, item.red4,\

item.red5, item.red6, item.blue,item.money,item.firstprize,item.secondprize))

self.log.info('将日期为:{}的数据存入{}'.format(item.lottery_date, self.filename))

def getresponsecontent(self, url):

try:

response = urllib.request.urlopen(url)

html = response.read().decode('utf-8')

except Exception as e:

self.log.error(u'Python 返回 url:{} 数据失败\n错误代码:{}\n'.format(url, e))

else:

self.log.info(u'Python 返回 url:{} 数据成功\n'.format(url))

# time.sleep(1) # 1秒返回一个结果 手动设置延迟防止被封

return html

if __name__ == '__main__':

st = GetCaiPiao()运行主程序get_caipiao.py文件

pycharm截图

当前目录下会自动生成 双色球.xls文件,截图如下:

代码分析:

mylog.py模块,主要是为程序提供log功能

log功能很重要,在大量爬取的时候,没有log帮助定位,很难找到错误点

save2excel.py模块,用于把数据存入excel表

主程序:

CaiPiaoItem类定义需要获取的数据

GetCaiPiao类为主程序

geturls方法 获取所有需要爬取的url地址

spider方法 提取每个url地址的详细内容(过滤数据)

pipelines方法 处理数据,数据的存储方式,这里使用的txt

getresponsecontent方法 负责发送请求,拿到响应文件(html)

上一篇: bs4爬虫实战二:获取双色球中奖信息

下一篇: bs4--mechanize模拟浏览器

- openvpn linux客户端使用

52230

- H3C基本命令大全

52149

- openvpn windows客户端使用

42298

- H3C IRF原理及 配置

39168

- Python exit()函数

33666

- openvpn mac客户端使用

30621

- python全系列官方中文文档

29319

- python 获取网卡实时流量

24284

- 1.常用turtle功能函数

24172

- python 获取Linux和Windows硬件信息

22542

- LangChain 1.0-Agent中间件-实现闭环(批准-编辑-拒绝动作)

124°

- LangChain 1.0-Agent中间件-汇总消息

123°

- LangChain 1.0-Agent中间件-删除消息

133°

- LangChain 1.0-Agent中间件-消息压缩

125°

- LangChain 1.0-Agent中间件-多模型动态选择

180°

- LangChain1.0-Agent-部署/上线(开发人员必备)

341°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

380°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

384°

- LangChain1.0-Agent记忆管理

362°

- LangChain1.0-Agent接入自定义工具与React循环

399°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江