最近痴迷于Python的逻辑控制,还有爬虫的一方面,原本的目标是拷贝老师上课时U盘的数据。后来发现基础知识掌握的并不是很牢固。便去借了一本Python基础和两本爬虫框架的书。便开始了自己的入坑之旅

言归正传

前期准备

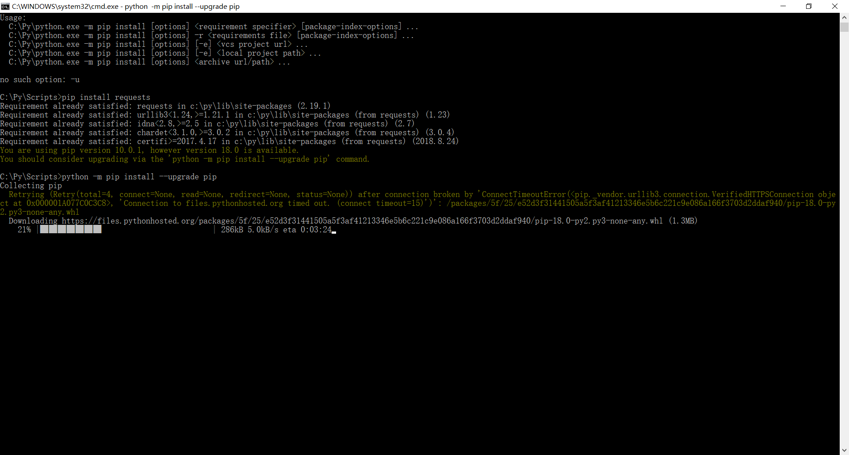

Import requests;我们需要引入这个包。但是有些用户环境并不具备这个包,那么我们就会在引入的时候报错

这个样子相信大家都不愿意看到那么便出现了一下解决方案

我们需要打开Cmd 然后进入到我们安装Python的Scripts目录下输入指令

pip install requests

当然还会出现下面的情况

又是一个报错是不是很烦 那么我们按它的提示升级一下组件 输入命令

python -m pip install --upgrade pip

安装成功后我们便可以正常的导入 requests

那么我们是不是就可以做一下什么了?比如说爬取一个网站的所有信息爬取下来?

import requests;

//导入我们需要的库

def GetName(url):

//定义一个函数并且传入参数Url

resp=requests.get(url);

//获取网页上的所有信息

//以文本的模型返回

return resp.text;

//定义一个字符串也就是我们要爬取的地址

url="https:xxxxxxxxxx";

//函数方法

def xieru():

//打开一个文本,以写入的方式写入二级制文本

fi=open('E://1.txt',"wb+");

//接受

con = GetName(url);

//返还的文本转换编码格式

ss=con.encode('utf-8')

//写入打开的文本中

fi.write(ss);

return 0;

xieru();

哈哈 上面的网址就打码了哦,大家自己脑补。

这是我爬取的内容