urllib高级用法--登陆和cookies的使用

发布时间:2018-09-06 19:33:14编辑:Run阅读(11110)

对于一些更高级的操作(比如Cookies处理,代理设置,登陆验证),urllib怎么实现?需要更强大的工具Handler登场了,有专门处理登录验证的,有处理Cookies的,用处理代理设置的,几乎做到http请求的所有事情。

Handler子类继承BaseHandler 类

HITPDefaultErrorHandler :用于处理Http响应错误,错误都会抛出 HTTPError 类型的异常。

HTTPRedirectHandler :用于处理重定向。

HTTPCookieProcessor :用于处理Cookies。

ProxyHandler :用于设置代理,默认代理为空。

HTTPPasswordMgr :用于管理密码,它维护了用户名和密码的表。

HTTPBasicAuthHandler :用于管理认证,如果一个链接打开时需要认证,那么可以用它来解决认证问题.

更多详情参考:https://docs.python.org/3/library/urllib.request.html#urllib.request.BaseHandler

利用Handler来构建Opener

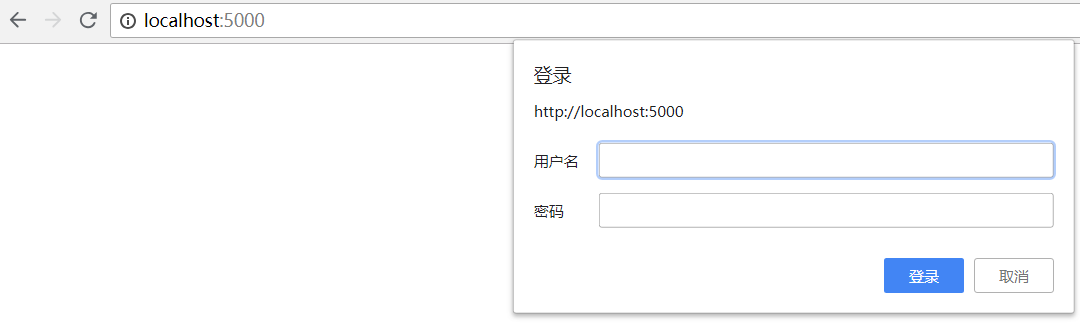

验证:有些网站打开就会提示输入用户名和密码,验证成功后才能查看页面

这样的请求页面,怎么办?借助HTTPBasicAuthHandler 就可以完成,完整代码如下:

#!/usr/bin/env python

# coding: utf-8

from urllib.request import HTTPPasswordMgrWithDefaultRealm

from urllib.request import HTTPBasicAuthHandler

from urllib.request import build_opener

from urllib.request import URLError

username = 'root'

password = '123456'

url = 'http://localhost:5000'

p = HTTPPasswordMgrWithDefaultRealm()

p.add_password(None, url, username, password)

auth_handler = HTTPBasicAuthHandler(p)

opener = build_opener(auth_handler)

try:

ret = opener.open(url)

html = ret.read().decode('utf8')

print(html)

except URLError as e:

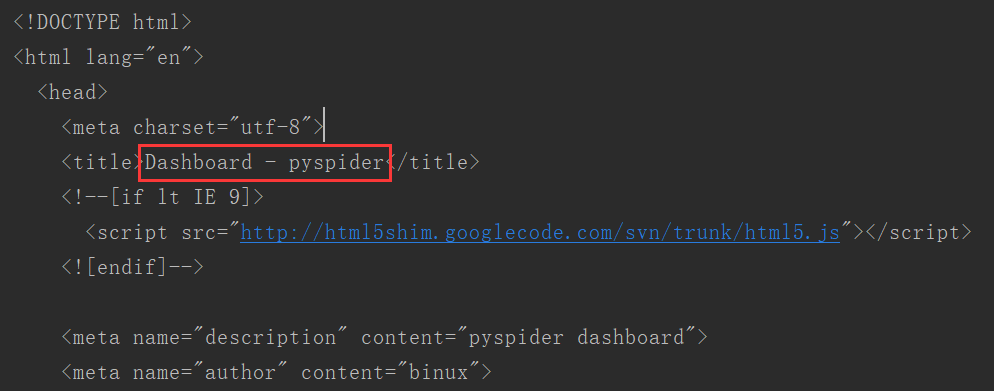

print(e.reason)运行结果,可以看到已经登录成功

代理IP的使用

在写爬虫的时候,免不了要使用代理,如果要添加代理,可以这样做:

from urllib.request import ProxyHandler,build_opener

from urllib.error import URLError

proxy_handler = ProxyHandler({

'http': 'http://163.158.203.206:8080',

})

opener = build_opener(proxy_handler)

try:

response = opener.open('https://www.baidu.com')

print(response.read().decode('utf8'))

except URLError as e:

print(e.reason)注释:使用了ProxyHandler,其参数是一个字典,键为协议类型(HTTP或者HTTPS等),value是代理链接,可以添加多个代理,利用Handler及build_opener()方法构造一个Opener,之后发送请求即可。

Cookies

Cookies的处理就需要相关的Handler了

实例:怎么获取网站的Cookies

代码如下:

import http.cookiejar

import urllib.request

cookie = http.cookiejar.CookieJar()

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

for item in cookie:

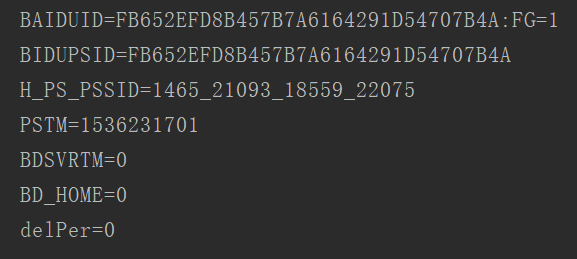

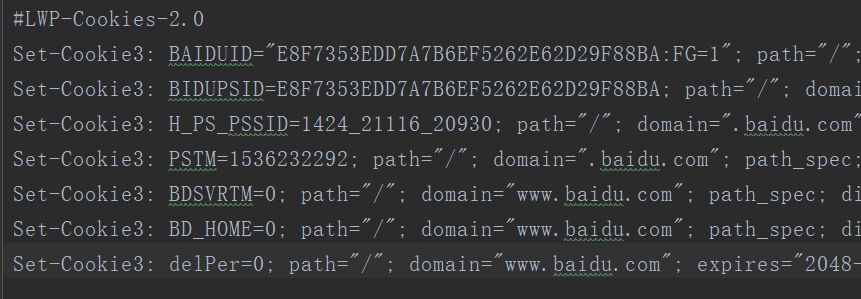

print(item.name + "=" + item.value)运行结果如下:

这里输出了每条Cookie的名称和值

如何输出成文件格式呢?代码如下:

import http.cookiejar

import urllib.request

filename = 'cookies.txt'

cookie = http.cookiejar.MozillaCookieJar(filename)

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

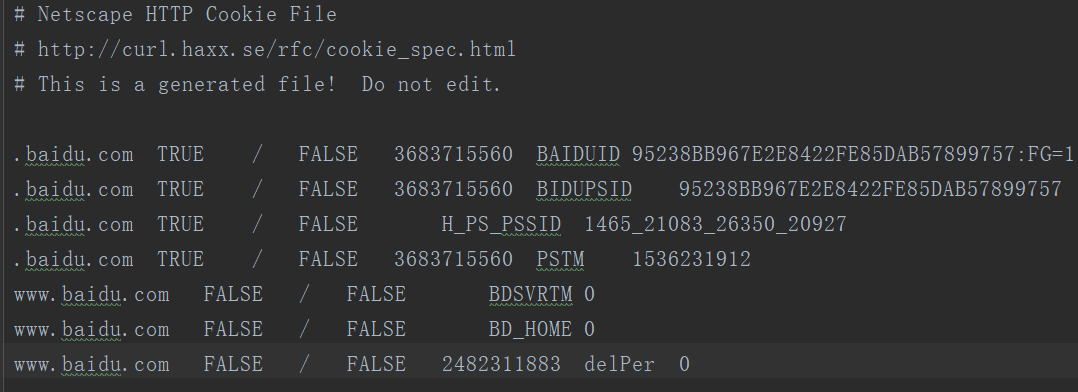

cookie.save(ignore_discard=True, ignore_expires=True)运行程序后,生成cookies.txt文件,内容如下:

另外,LWPCookieJar同样可以读取和保存Cookies,但是保存的格式和MozillaCookieJar不一样,要保存成LWP格式的Cookies文件,可以在声明时就改为:cookie = http.cookiejar.LWPCookieJar(filename),代码如下:

import http.cookiejar

import urllib.request

filename = 'cookies.txt'

cookie = http.cookiejar.LWPCookieJar(filename)

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

response = opener.open('http://www.baidu.com')

cookie.save(ignore_discard=True, ignore_expires=True)运行后,生成cookies.txt文件内容如下:

生成Cookies文件后,怎样从文件中读取并利用呢?

下面以LWPCookieJar格式为例来看一下:

import http.cookiejar

import urllib.request

cookie = http.cookiejar.LWPCookieJar()

cookie.load('cookies.txt', ignore_discard=True, ignore_expires=True)

handler = urllib.request.HTTPCookieProcessor(cookie)

opener = urllib.request.build_opener(handler)

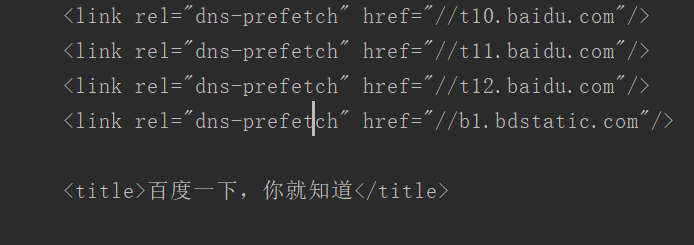

response = opener.open('http://www.baidu.com')

print(response.read().decode('utf8'))运行结果如下:

注释:这里调用load()方法来读取本地的Cookies文件,获取到了Cookies的内容,前提是首先生成了LWPCookieJar格式的Cookies,并保存成文件,然后读取Cookies使用同样的方法构建Handler和Opener即可完成操作

这些是urllib库中request模块的基本用法,想知道更多,可以参考:

官方文档说明:https://docs.python.org/3/library/urllib.request.html#basehandler-objects

上一篇: 初识urllib

下一篇: urllib异常处理

- openvpn linux客户端使用

52132

- H3C基本命令大全

52011

- openvpn windows客户端使用

42221

- H3C IRF原理及 配置

39064

- Python exit()函数

33576

- openvpn mac客户端使用

30532

- python全系列官方中文文档

29173

- python 获取网卡实时流量

24189

- 1.常用turtle功能函数

24091

- python 获取Linux和Windows硬件信息

22428

- LangChain1.0-Agent-部署/上线(开发人员必备)

218°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

245°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

255°

- LangChain1.0-Agent记忆管理

245°

- LangChain1.0-Agent接入自定义工具与React循环

268°

- LangChain1.0-Agent开发流程

255°

- LangChain1.0调用vllm本地部署qwen模型

284°

- LangChain-1.0入门实践-搭建流式响应的多轮问答机器人

284°

- LangChain-1.0入门实战-1

287°

- LangChain-1.0教程-(介绍,模型接入)

293°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江