Ai之大模型进阶模型微调-Unsloth微调-实战5.2

发布时间:2025-03-20 10:42:40编辑:123阅读(2219)

在之前的文章中学习了如何使用 Ollama 运行 Ollama 平台上的开源模型,其实 Ollama 也是可以支持直接从 Hugging Face 上拉取并运行模型了,所以可以把刚刚训练好的模型上传到 Hugging Face 上。

GGUF 是一种高效的格式,它支持多种量化方法(如 4 位、8 位、16 位量化),可以显著减小模型文件的大小,便于存储和传输,适合在资源受限的设备上运行模型,例如在 Ollama 上部署时。量化后的模型在资源受限的设备上运行更快,适合边缘设备或低功耗场景。

将微调后的模型保存为 GGUF 格式,将微调后的模型上传到huggingface。

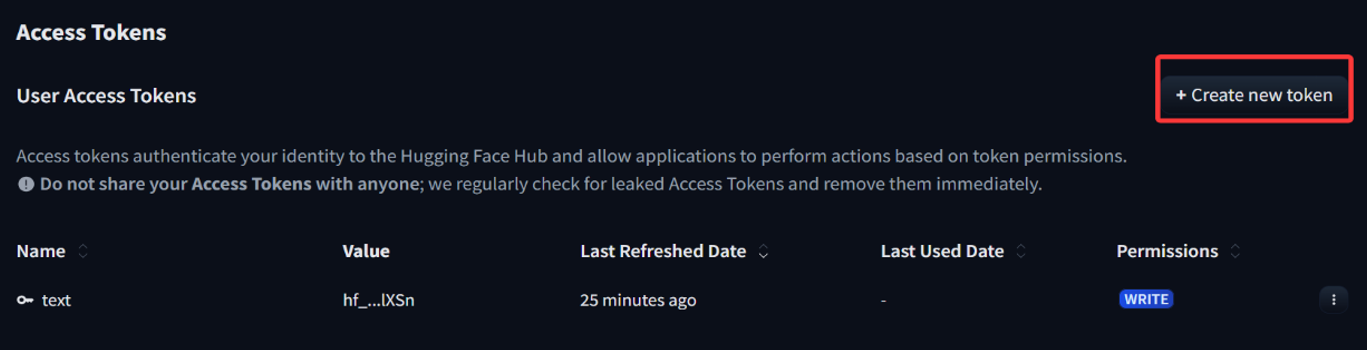

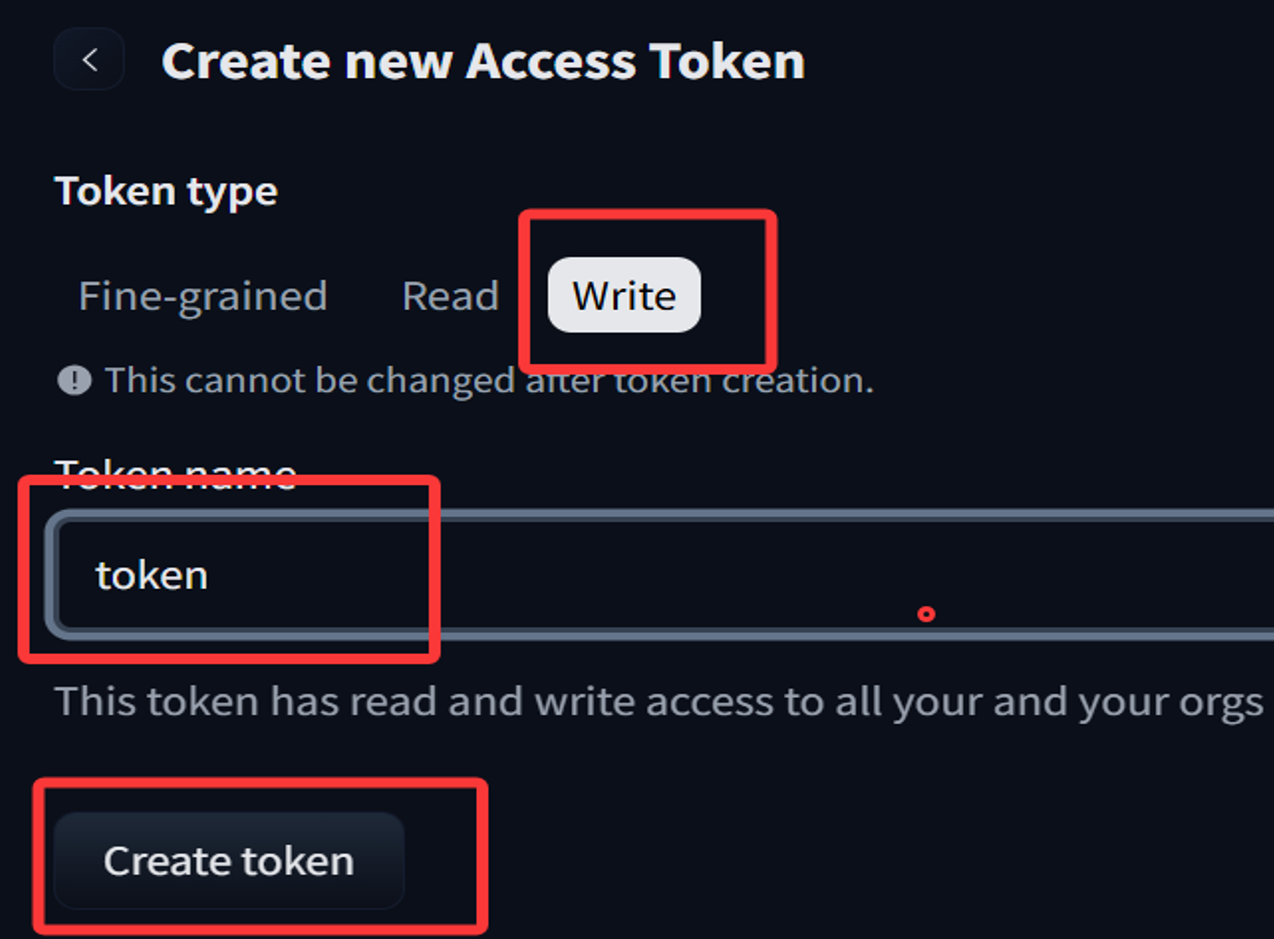

登录huggingface,可以到 HuggingFace 的 Settings - Access Tokens 下创建一个自己的 Token。

注意一定要配置位写权限,不然后面没有权限创建仓库。

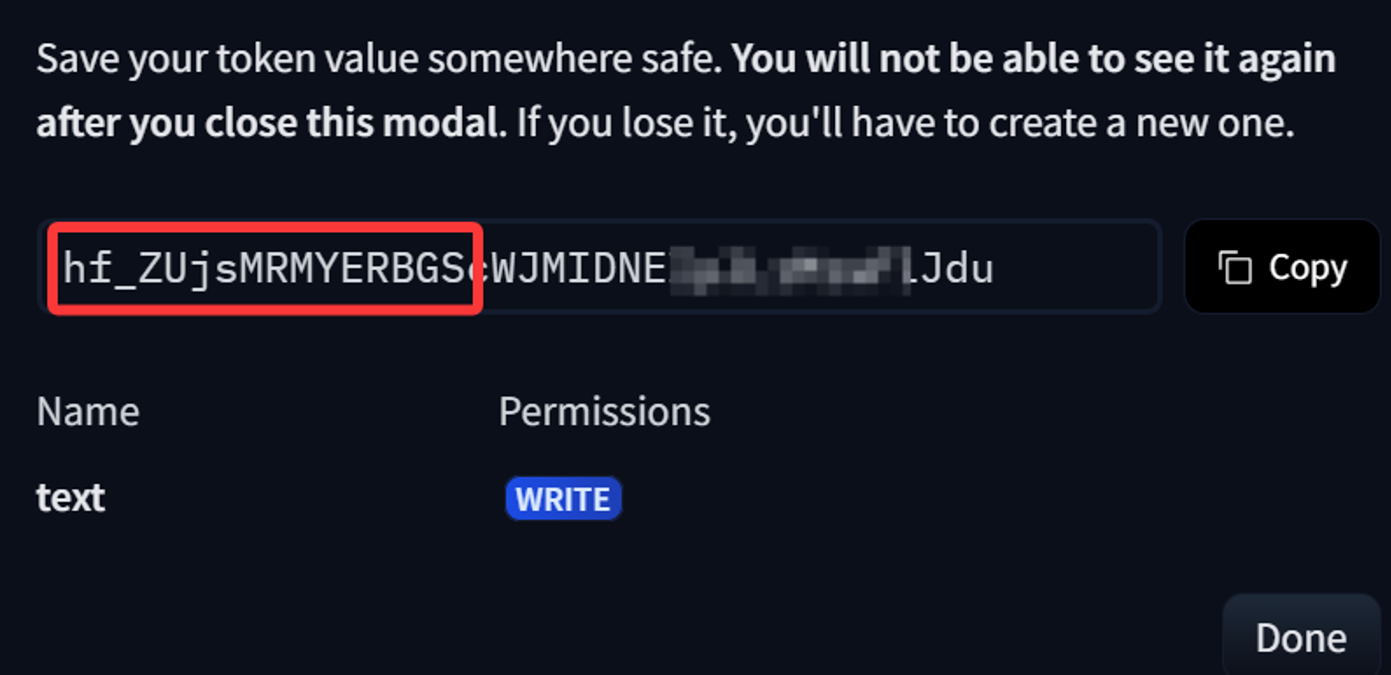

创建好后,复制token就好了

代码如下:

# 将模型保存为8位量化格式(Q8_0)

# 8 位量化这种格式小且运行快,适合部署到资源受限的设备

if True:model.save_pretrained_gguf("model", tokenizer)

# 将模型保存为16位量化格式(f16)

# 16 位量化精度更高,但文件稍大

if False:model.save_pretrained_gguf("model", tokenizer, quantization_method = "f16")

# 将模型保存为4位量化格式(q4_k_m)

# 4 位量化文件最小,但精度可能稍低

if False:model.save_pretrained_gguf("model", tokenizer, quantization_method = "q4_k_m")

# 用于创建一个新的模型仓库

from huggingface_hub import create_repo

model_name = 'SamTaoQaq/suanming'

huggingface_hub_token = 'hf_zslflzYDYnUSZGXSKbmDFQSemAXLFPxxxx'

# 在hugging face hub上创建一个新的模型仓库

create_repo(model_name, token=huggingface_hub_token, exist_ok=True)

# 将模型和分词器上传到hugging face hub上的仓库

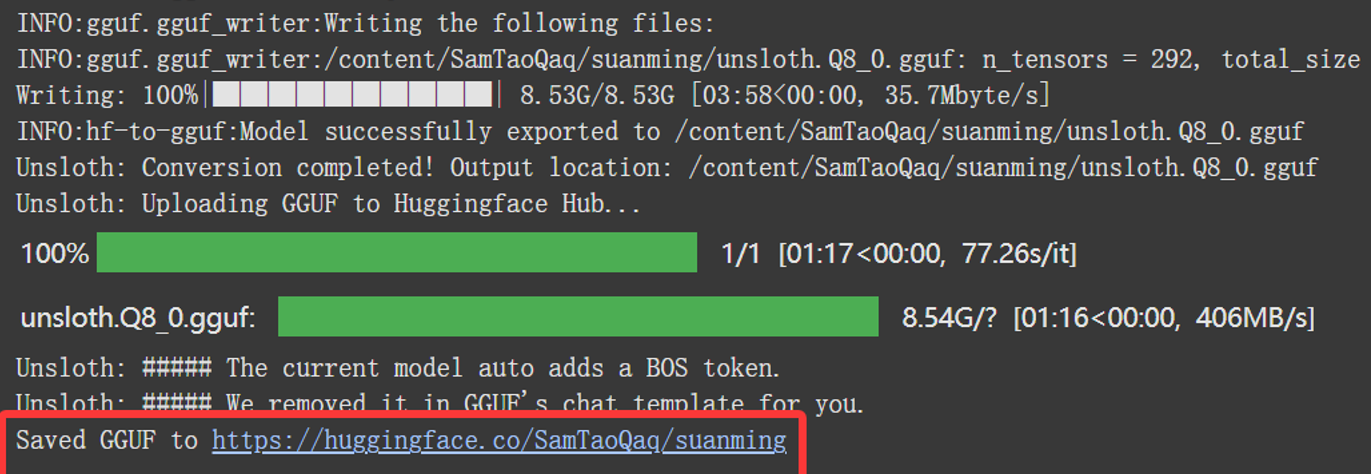

model.push_to_hub_gguf(model_name, tokenizer,token=huggingface_hub_token)结果如下:

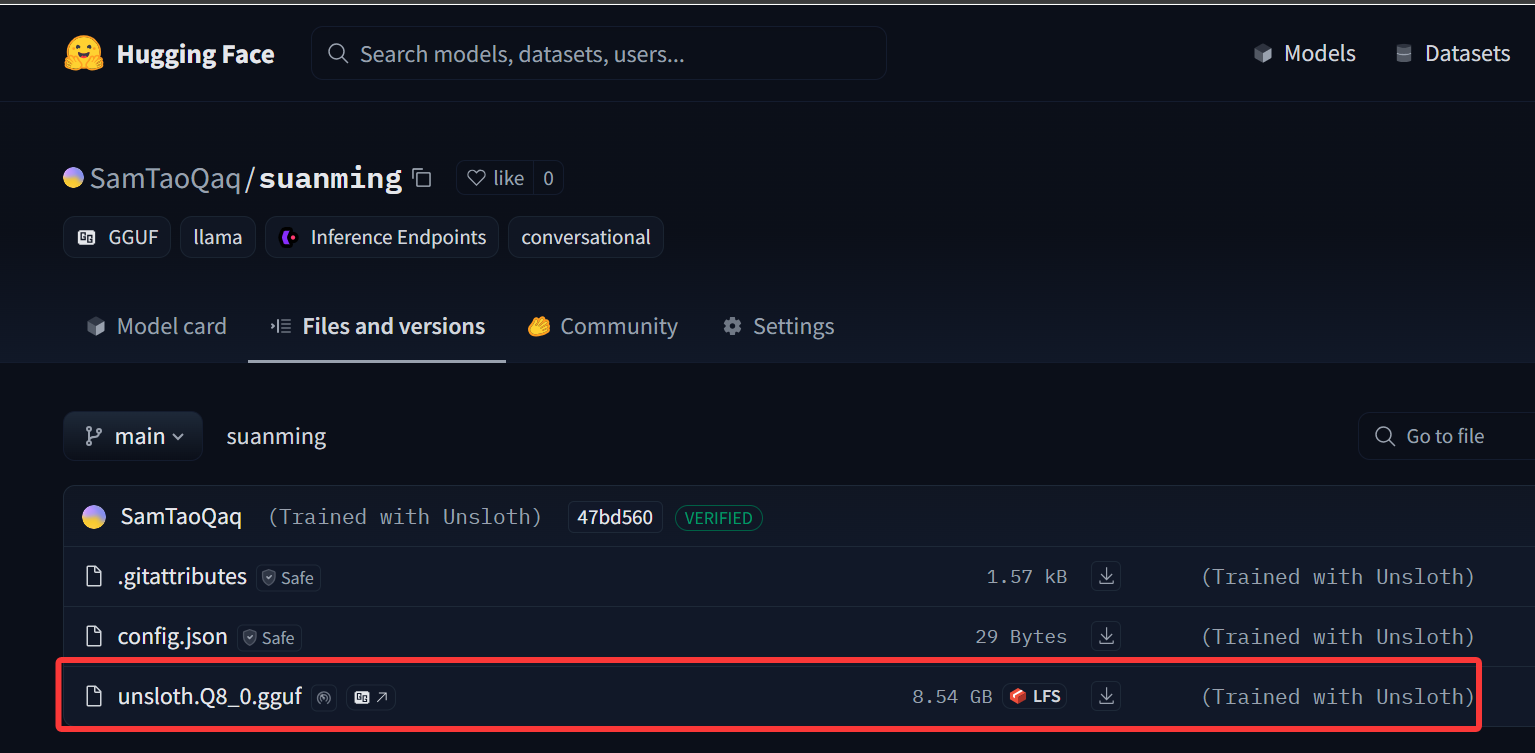

复制地址:https://huggingface.co/SamTaoQaq/suanming

去Hugging Face上查看一下:

使用Ollama运行HuggingFace模型

ollama支持直接从Huggingface拉去模型,格式如下:

ollama run hf.co/SamTaoQaq/suanming

如下:

上一篇: Ai之大模型进阶模型微调-Unsloth微调-实战5.1

下一篇: OCR使用深度学习识别图形验证码

- openvpn linux客户端使用

52230

- H3C基本命令大全

52150

- openvpn windows客户端使用

42298

- H3C IRF原理及 配置

39168

- Python exit()函数

33666

- openvpn mac客户端使用

30621

- python全系列官方中文文档

29319

- python 获取网卡实时流量

24284

- 1.常用turtle功能函数

24172

- python 获取Linux和Windows硬件信息

22542

- LangChain 1.0-Agent中间件-实现闭环(批准-编辑-拒绝动作)

124°

- LangChain 1.0-Agent中间件-汇总消息

124°

- LangChain 1.0-Agent中间件-删除消息

134°

- LangChain 1.0-Agent中间件-消息压缩

125°

- LangChain 1.0-Agent中间件-多模型动态选择

180°

- LangChain1.0-Agent-部署/上线(开发人员必备)

341°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

382°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

385°

- LangChain1.0-Agent记忆管理

362°

- LangChain1.0-Agent接入自定义工具与React循环

400°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江