Ai之大模型进阶模型微调--理论篇3

发布时间:2025-03-14 14:28:09编辑:987阅读(2717)

微调技术原理与价值

定义:模型微调指在预训练模型基础上,使用特定数据集或方法对模型参数进行优化,以增强其在特定任务中的表现.

例如,通用大模型通过医疗数据微调后,可成为医学影像诊断专家。

必要性

降低训练成本:避免从零训练大模型的高资源消耗,利用预训练模型的通用知识作为起点

防止过拟合:针对特定任务的小数据集调整部分参数,而非全量更新,减少过拟合风险

垂直领域适配:解决通用模型在专业场景(如金融、法律)中表现不足的问题

主流微调方法

1 全量微调(Full Fine-Tuning)

特点:更新所有模型参数,适合资源充足场景,性能最优但计算成本高

应用场景:需深度适配的高价值任务(如复杂对话系统)

2 参数高效微调(PEFT)

LoRA:通过低秩矩阵分解调整权重,仅训练少量新增参数,成本降低80%以上

Adapter:插入轻量适配模块,保留原参数的同时适配多任务

BitFit:仅微调偏置项(bias),适用于极低资源场景

3 强化学习微调(RLHF)

原理:结合人类反馈优化模型输出,提升交互质量(如ChatGPT的对话流畅性)

案例:DeepSeek-R1通过RLHF优化数学推理能力

4 创新技术:批判性微调(CFT)

突破点:仅需8个H100 GPU训练1小时、5万样本,性能媲美需140倍资源的传统方法

优势:在数学基准(MATH、AIME24)上平均提升4%-10%,样本效率提高40倍

通俗来讲,微调的作用可以让通用的AI进化成领域的专家

为什么需要微调?

我们平常接触到的大模型如GPT, DeepSeek等都是基于海量通用数据训练而成的,它们具备非常强大的语言理解和生成能力,

能够处理多种自然语言任务,但是这些模型在特定领域任务上表现并不理想,下面是需要微调的几个主要原因:

1 领域专业化:让模型掌握“行业黑话”

原因:通用模型的训练数据覆盖面广,但难以深入垂直领域的知识体系和专业术语。例如医学诊断需理解病理特征,

法律咨询需熟悉法律逻辑。当模型在专业领域认知不够时,会出现比较严重的幻觉问题,也就是胡乱回答,微调可以很好

的解决这个问题。

典型场景

医学问答:输入病状描述,模型需结合医学知识库输出可信的初步诊断建议。

法律咨询:分析未成年人合同时,需准确引用《民法典》相关条数。

2 任务适配:调整模型的“输出模式”

原因:不同任务对模型能力的要求差异显著--分类任务需结构化输出,生成任务需语言创造力。

典型场景

文案生成:训练模型以幽默风格撰写广告文案(例 这杯咖啡比老板的早安更提神)。

心里咨询:从情绪识别转向疏导对话,需调整输出为引导提问而非结论性判断。

3 能力纠偏:解决模型的“偏科问题”

原因:通用模型可能对某些任务过度敏感(如政治倾向)或表现不足(如冷门领域的长尾问题)。

典型场景

民俗推理:输入生辰八字与手相特征时,模型需按传统命理逻辑生成连贯解释,而非套用通用话术。

边缘案例:处理宠物能否继续遗产时,需结合继承法细则而非泛泛回答。

安全与成本

数据安全:当训练数据涉及隐私(如患者病历,企业内部文档)时,本地化微调可避免云端传输风险。

成本效率:相比从头训练(需百万级算力),微调仅需要少量领域数据即可显著提升任务表现,适合中小规模企业。

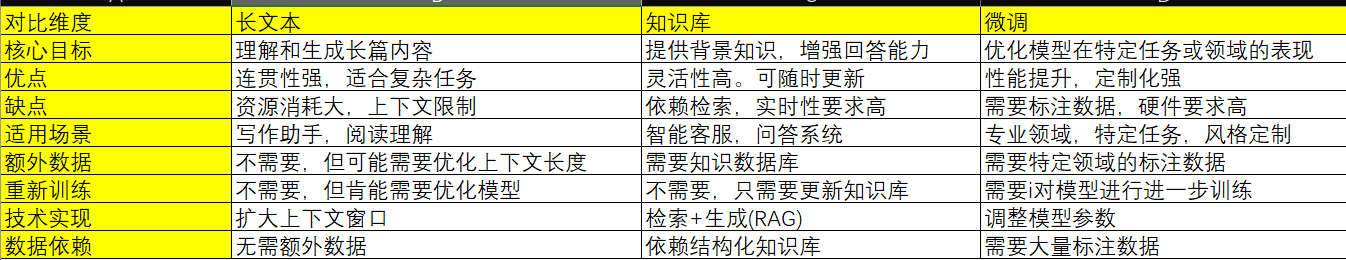

长文本&知识库&微调的区别

现在各大模型都支持超长上下文,从最开始的4k到现在的200k,我们不能用一个比较完善的提示词来解决这些问题吗?

现在各种知识库工具这么灵活,不能自己搭建一个非常全面的数据库来解决这些问题吗?

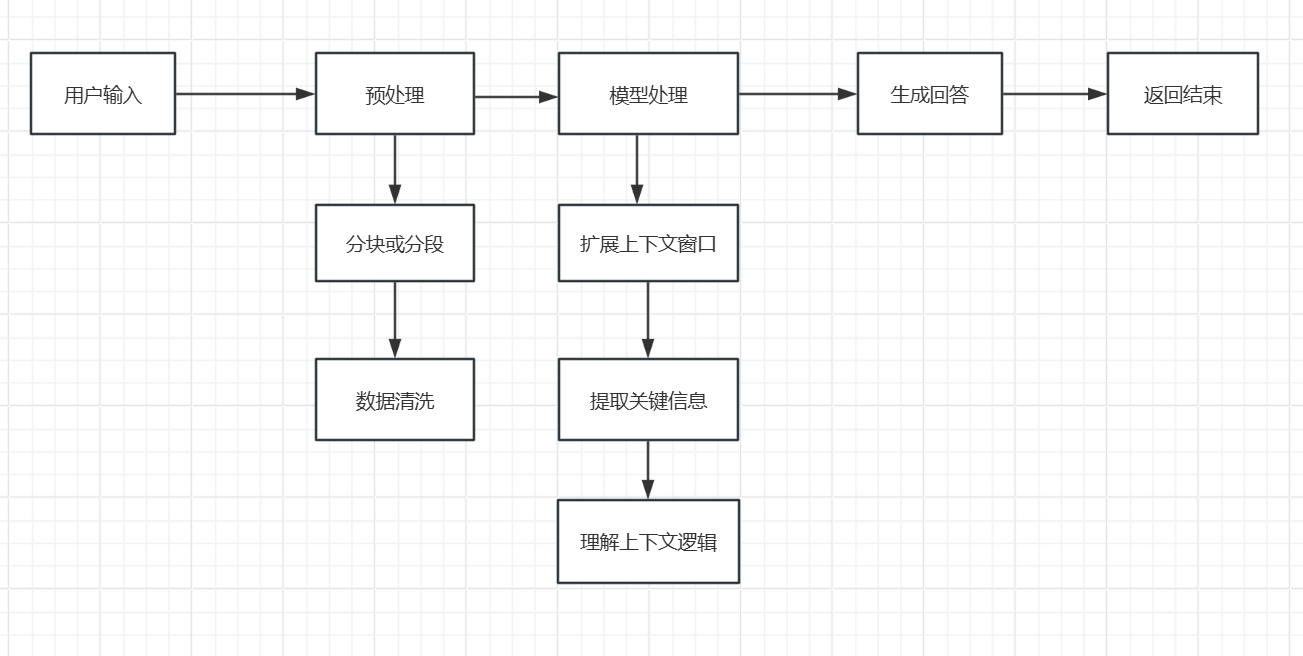

长文本

通俗理解:模型要读完一篇长篇小说,然后回答关于小说情节的问题,这就是“长文本”的任务,模型需要处理很长的文本

内容,理解其中的细节和逻辑,然后给出准确的答案。

优点:

连贯性强:能够生成或理解长篇幅的内容,保持逻辑和语义的连贯性。

适合复杂任务:适合处理需要深入理解背景信息的任务,比如长篇阅读理解或复杂的文章生成。

缺点:

对话限制:只在当前上下文有效。

资源消耗大:处理长文本需要更多的计算资源和内存,因为模型需要同时处理大量信息。

上下文限制:即使是强大的模型,也可能因为上下文长度限制而丢失一些细节信息。

适用场景:

写作助手:生成长篇博客、报告或故事。

阅读理解:处理长篇阅读理解任务,比如学术论文或小说。

对话系统:在需要长篇回答的场景中,解释复杂的概念。

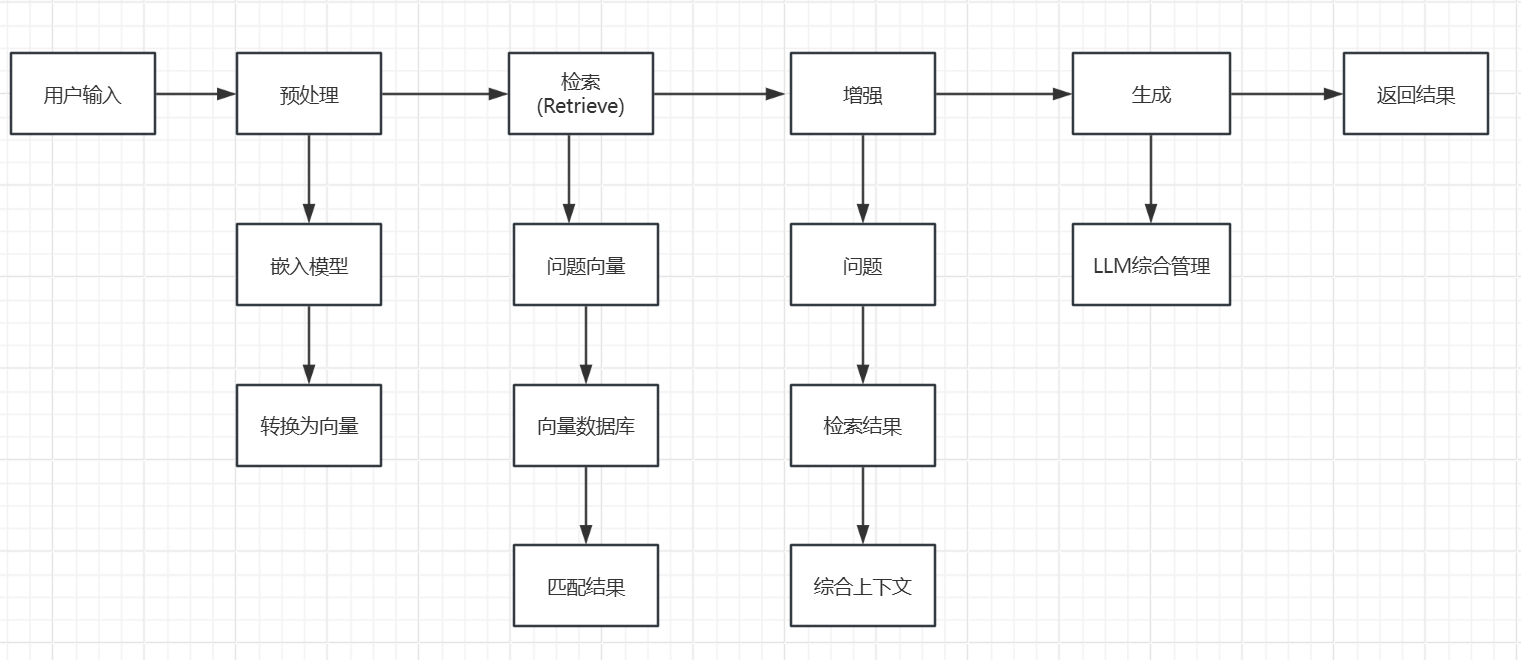

知识库

通俗理解:知识库就像一个巨大的资料库,模型可以在里面查找信息来回答问题。比如你问模型:“相对论是什么?”模型

可以去知识库中查找相关内容,然后给出详细的解释。

优点:

准确性高:只要找到的,都能回答出来。

灵活性高:可以随时更新知识库中的内容,让模型获取最新的信息。

扩展性强:不需要重新训练模型,只需要更新知识库,就能让模型回答新的问题。

缺点:

依赖检索:如果知识库中的信息不准确或不完整,模型的回答也会收到影响。

实时性要求高:需要快速检索和整合知识库中的信息,对性能有一定要求。

适用场景:

智能客服:快速查找解决方案,回答用户的问题。

问题系统:结合知识库回答复杂、需要背景的知识问题。

研究辅助:帮助研究人员快速找到相关的文献或数据。

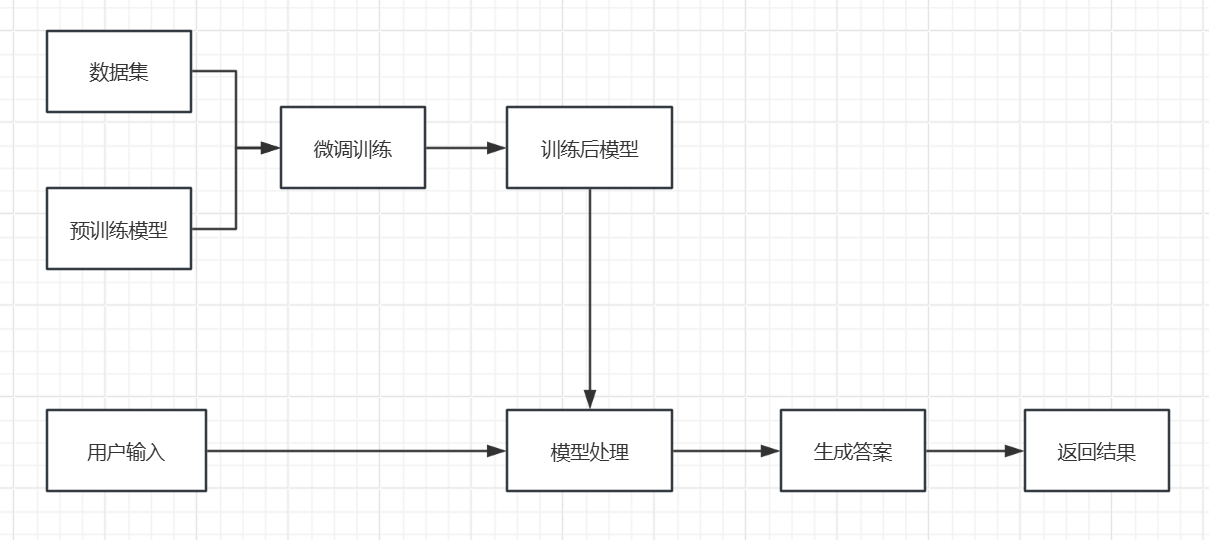

微调

通俗理解:微调是让模型提前学习一些特定的知识,比如某个领域的专业术语或者特定的任务技巧,这样它在实际任务中就能表现得更好。比如,让模型学习了医疗知识,那么它在回答医学相关的问题时就能更准确。

优点:

性能提升:显著提升模型在特定任务或领域的表现。

定制化强:可以根据需求调整模型的行为,比如改变回答风格或优化任务性能。

缺点:

训练成本高:微调需要一定的计算资源,尤其是GPU。

需要标注数据:需要准备特定领域的标注数据,这可能需要时间和精力。

时效性差:补充数据需要重新训练。

适用场景:

专业领域:如医疗,法律,金融等,让模型理解专业术语和逻辑。

特定任务:如文本分类,情感分析等,优化模型的性能。

风格制定:让模型生成符合某种风格的内容,比如幽默,正式或古风。

对比

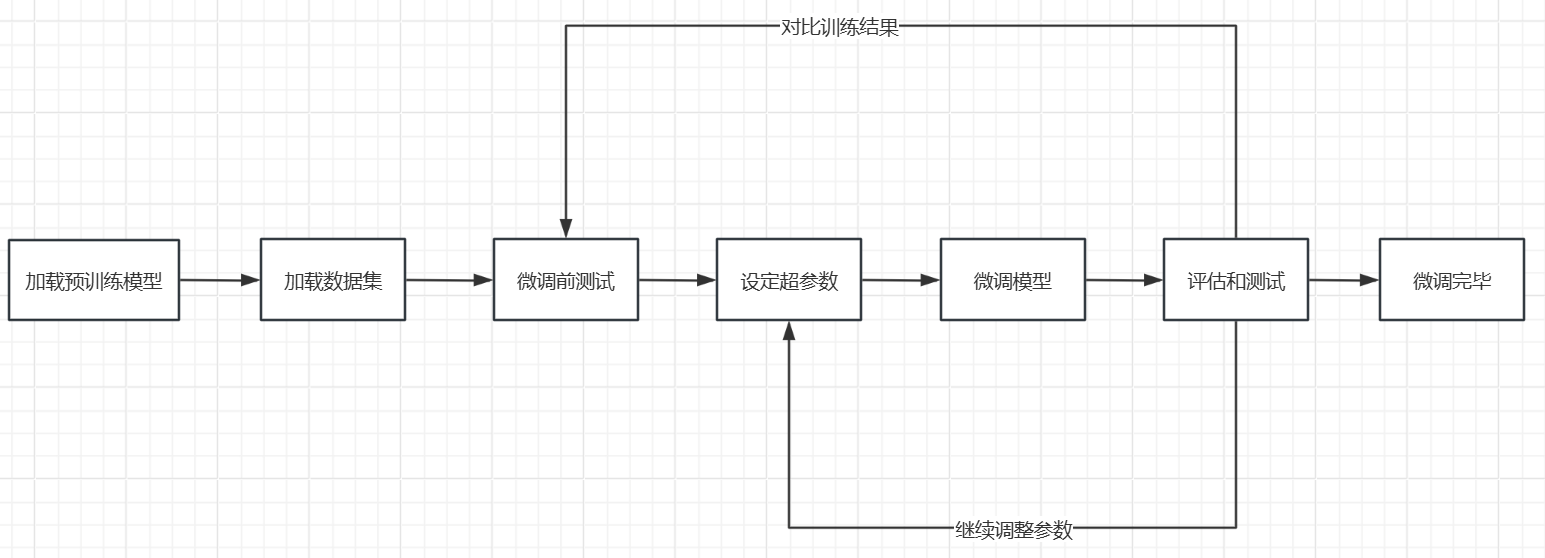

微调的基本流程

常见模型微调的过程:

1 选定一款用于微调的预训练模型,并加载。

2 准备好用于模型微调的数据集,并加载。

3 准备一些问题,对微调前的模型进行测试(用于后续对比)。

4 设定模型微调需要的超参数。

5 执行模型微调训练。

6 还使用上面的问题,对微调后的模型进行测试,并比对效果。

7 如果效果不满意,继续调整前面的数据集以及各种超参数,直到达到满意效果。

8 得到微调好的模型。

概念1:预训练模型

预训练模型就是我们选择用来微调的基础模型。这些模型(如GPT,DeepSeek等)已经在大量的通用数据上进行了训练,能够处理多种语言任务,选择一个合适的预训练模型是微调的第一步。为了成本和运行效率考虑,会选择一些开源的小参数模型来进行微调,比如Mate的llama,阿里额qwen,DeepSeek(蒸馏版)。

概念2:数据集

数据集就是我们用于模型微调的数据,这些数据需要经过标注和整理,以便模型能够学习到特定领域的模式和规律。比如,如果想让模型学会算命,就需要准备一些标注好的命理学知识作为数据集。一般情况下,用于模型训练的数据集是没有对格式强要求的,比较常见的结构化数据格式:json,csv,xml等都是支持的。

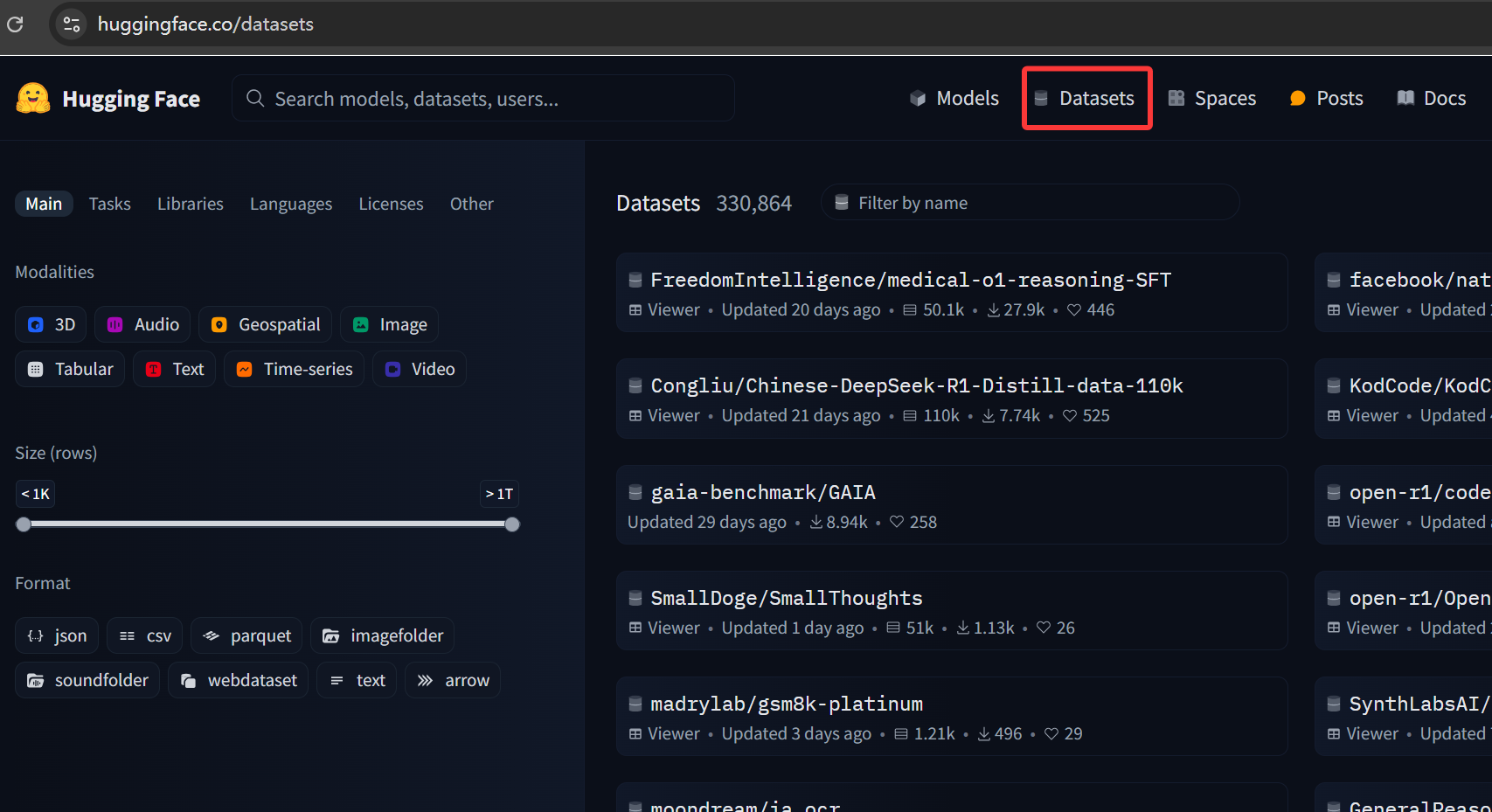

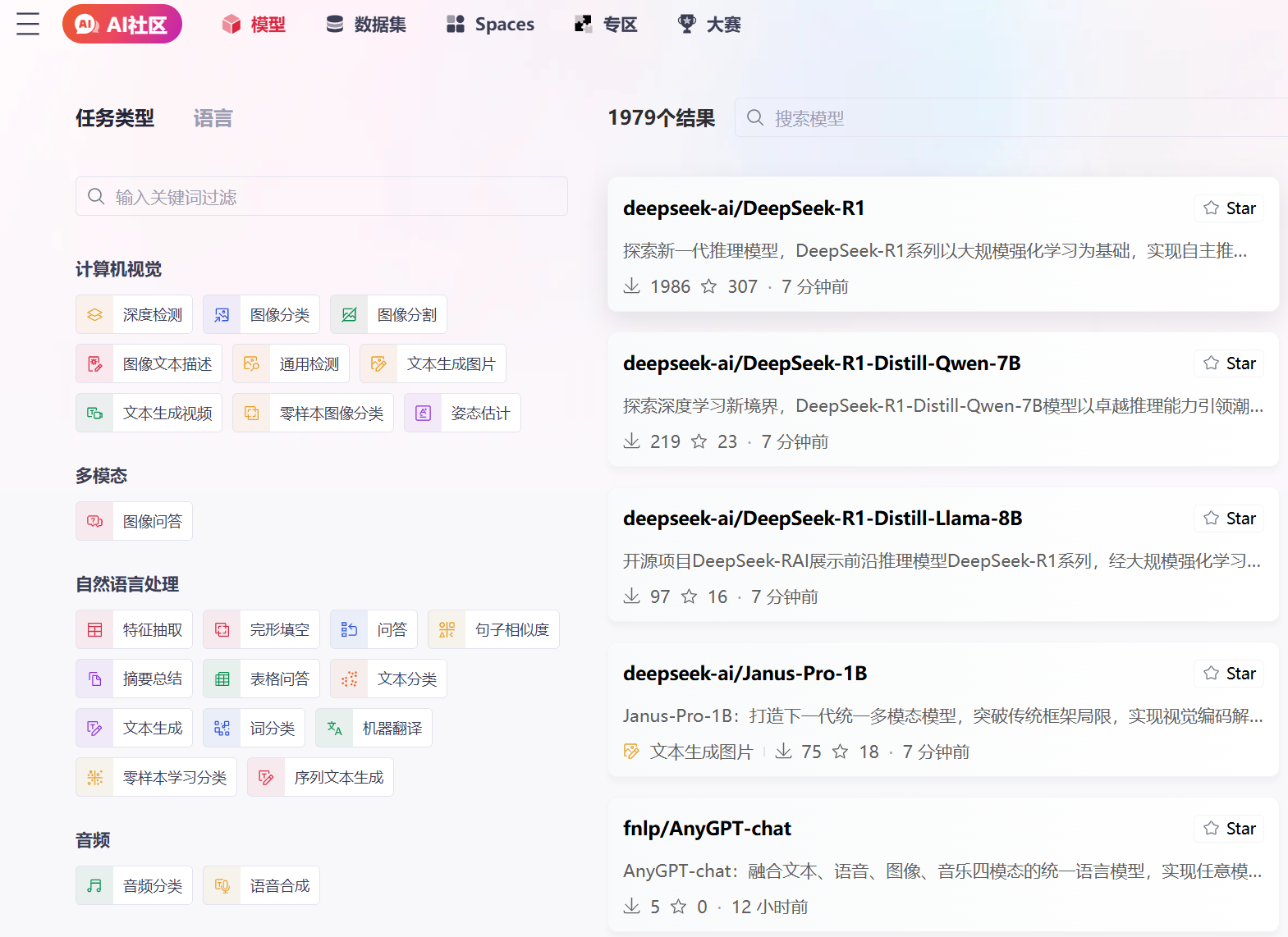

两个获取公开数据集的网站:

1 Hugging Face(访问需要梯子)它为开发者提供了一个集中化的平台,用于分享,获取和使用预训练模型的数据集,是AI模型和数据共享的中心。https://huggingface.co/datasets

2 GitCode 如果没有梯子,也可以选择一些国内的类似AI社区。https://ai.gitcode.com/models

概念3:超参数

超参数就像是你在给模型“补课”之前制定的教学计划和策略。它们决定了你如何教学,教学的强度以及教学的方向。如果你选择的教学计划不合适(比如补课时间短,讲解速度太快或复习策略不合理),可能会导致学生学习效果不好。同样,如果你选择的超参数不合适,模型的性能也不可能理想。

上一篇: Ai之大模型加知识库检索RAG-实战2

- openvpn linux客户端使用

51777

- H3C基本命令大全

51466

- openvpn windows客户端使用

41866

- H3C IRF原理及 配置

38644

- Python exit()函数

33134

- openvpn mac客户端使用

30122

- python全系列官方中文文档

28799

- python 获取网卡实时流量

23790

- 1.常用turtle功能函数

23707

- python 获取Linux和Windows硬件信息

22074

- Ubuntu本地部署dots.ocr

137°

- Python搭建一个RAG系统(分片/检索/召回/重排序/生成)

2303°

- Browser-use:智能浏览器自动化(Web-Agent)

2996°

- 使用 LangChain 实现本地 Agent

2504°

- 使用 LangChain 构建本地 RAG 应用

2449°

- 使用LLaMA-Factory微调大模型的function calling能力

3064°

- 复现一个简单Agent系统

2450°

- LLaMA Factory-Lora微调实现声控语音多轮问答对话-1

3265°

- LLaMA Factory微调后的模型合并导出和部署-4

5381°

- LLaMA Factory微调模型的各种参数怎么设置-3

5199°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江