python3中request.urlo

发布时间:2019-09-26 07:25:30编辑:auto阅读(2112)

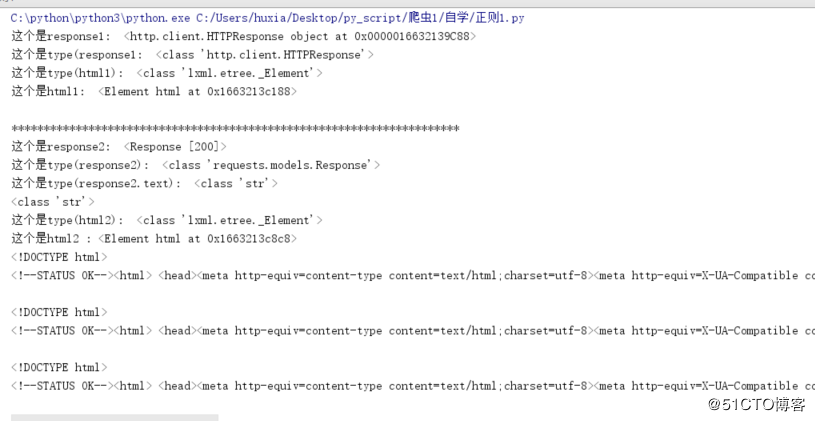

爬虫里面,我们不可避免的要用urllib中的urlopen()和requests.get()方法去请求或获取一个网页的内容,这里面的区别在于urlopen打开URL网址,url参数可以是一个字符串url或者是一个Request对象,返回的是http.client.HTTPResponse对象.http.client.HTTPResponse对象大概包括read()、readinto()、getheader()、getheaders()、fileno()、msg、version、status、reason、debuglevel和closed函数,其实一般而言使用read()函数后还需要decode()函数,返回的网页内容实际上是没有被解码或的,在read()得到内容后通过指定decode()函数参数,可以使用对应的解码方式。

requests.get()方法请求了站点的网址,然后打印出了返回结果的类型,状态码,编码方式,Cookies等内容

我在刚学到他们的时候也很懵逼,自己慢慢的琢磨,然后用个笨办法写了个这个来做区别

使用方法和他们区别的代码如下:

from lxml import etree

import requests

from urllib import request

url = "http://www.baidu.com/"

req = request.Request(url)

response1 = request.urlopen(req)

html1 = etree.HTML(response1.read())

print("这个是response1: ", response1)#打印出response1是什么鬼

print("这个是type(response1: " , type(response1))#打印出response1的类型

print("这个是type(html1): " , type(html1)) #打印html1的类型

print("这个是html1: " , html1)#打印出response1的用etree解析为html网页元素

#打印网页的文本信息,由于这个response1只能调用一次所以这里会打印出空

print(response1.read().decode())#打印出网页源码的文本信息

print('*'*70)

response2 = requests.get(url)

html2 = etree.HTML(response2.text)

print("这个是response2: ",response2)#打印出response2的内容

print("这个是type(response2): " , type(response2))#打印出response2的类型

print("这个是type(response2.text): " , type(response2.text))#打印出response2用text输出是的类型

print(type(response2.content.decode()))#打印出内容解码的类型

print("这个是type(html2): ", type(html2))#打印出response2用etree解析为网页元素信息的html2的类型

print("这个是html2 :", html2)#打印出response2用etree解析为网页元素信息的html2

#打印网页的文本信息,用resquests有三种方法可以打印出网页的信息,这三种方法打印出来的都一样的

response2.encoding = 'utf-8'#给网页指定编码信息,是为了用text输出网页文本信息的

print(response2.text)#打印出网页的文本信息

print(response2.content.decode())#打印出网页源码的文本信息,这样写是为了避免出现中文乱码

print(str(response2.content,"utf-8"))#打印出网页源码的文本信息,这样写是为了避免出现中文乱码结果如下:

requests对象的get和post方法都会返回一个Response对象,这个对象里面存的是服务器返回的所有信息,包括响应头,响应状态码等。其中返回的网页部分会存在.content和.text两个对象中。两者区别在于,content中间存的是字节码,而text中存的是Beautifulsoup根据猜测的编码方式将content内容编码成字符串。直接输出content,会发现前面存在b'这样的标志,这是字节字符串的标志,而text是',没有前面的b,对于纯ascii码,这两个可以说一模一样,对于其他的文字,需要正确编码才能正常显示。大部分情况建议使用.text,因为显示的是汉字,但有时会显示乱码,这时需要用.content.decode('utf-8'),中文常用utf-8和GBK,GB2312等。这样可以手工选择文字编码方式。.text是现成的字符串,.content还要编码,但是.text不是所有时候显示都正常,这是就需要用.content进行手动编码

简而言之:

text返回的是Unicode型的数据

content返回的是是二进制的数据。

也就是说,如果你想取文本,可以通过r.text。

如果想取图片,文件,则可以通过r.content

再附上一张requests的图:

图来自:

https://www.cnblogs.com/puresoul/p/7488488.html

上一篇: python3 搜索关键字小程序

下一篇: python3 列表的增删改查

- openvpn linux客户端使用

52052

- H3C基本命令大全

51917

- openvpn windows客户端使用

42147

- H3C IRF原理及 配置

38994

- Python exit()函数

33492

- openvpn mac客户端使用

30443

- python全系列官方中文文档

29080

- python 获取网卡实时流量

24109

- 1.常用turtle功能函数

24017

- python 获取Linux和Windows硬件信息

22366

- LangChain1.0-Agent-部署/上线(开发人员必备)

113°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

150°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

163°

- LangChain1.0-Agent记忆管理

148°

- LangChain1.0-Agent接入自定义工具与React循环

173°

- LangChain1.0-Agent开发流程

161°

- LangChain1.0调用vllm本地部署qwen模型

177°

- LangChain-1.0入门实践-搭建流式响应的多轮问答机器人

185°

- LangChain-1.0入门实战-1

184°

- LangChain-1.0教程-(介绍,模型接入)

193°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江