Python脚本自动下载小说

发布时间:2019-08-28 09:06:24编辑:auto阅读(2405)

本人喜欢在网上看小说,一直使用的是小说下载阅读器,可以自动从网上下载想看的小说到本地,比较方便。最近在学习Python的爬虫,受此启发,突然就想到写一个爬取小说内容的脚本玩玩。于是,通过在逐浪上面分析源代码,找出结构特点之后,写了一个可以爬取逐浪上小说内容的脚本。

具体实现功能如下:输入小说目录页的url之后,脚本会自动分析目录页,提取小说的章节名和章节链接地址。然后再从章节链接地址逐个提取章节内容。现阶段只是将小说从第一章开始,每次提取一章内容,回车之后提取下一章内容。其他网站的结果可能有不同,需要做一定修改。在逐浪测试过正常。

分享此代码,一是做个记录,方便自己以后回顾。二么也想抛砖引玉,希望各路大神不吝赐教。

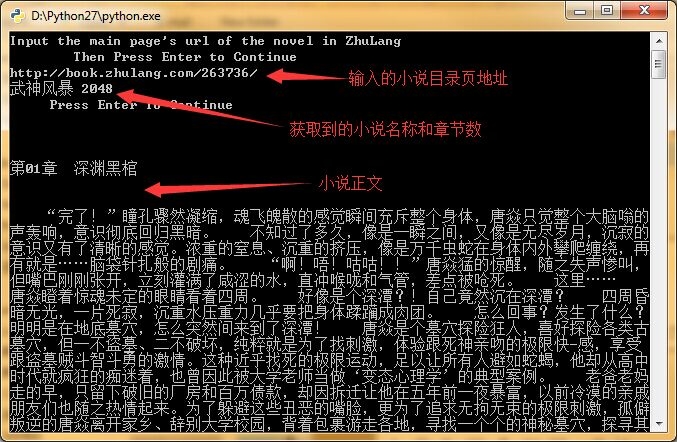

下面是我用来测试的页面:http://book.zhulang.com/263736/

效果如下:

实现的源代码如下,请各位指教:

#-*-coding:utf8-*-

#!/usr/bin/python

# Python: 2.7.8

# Platform: Windows

# Program: Get Novels From Internet

# Author: wucl

# Description: Get Novels

# Version: 1.0

# History: 2015.5.27 完成目录和url提取

# 2015.5.28 完成目录中正则提取第*章,提取出章节链接并下载。在逐浪测试下载无误。

from bs4 import BeautifulSoup

import urllib2,re

def get_menu(url):

"""Get chapter name and its url"""

user_agent = "Mozilla/5.0 (Windows NT 6.1; WOW64; rv:39.0) Gecko/20100101 Firefox/39.0"

headers = {'User-Agent':user_agent}

req = urllib2.Request(url,headers = headers)

page = urllib2.urlopen(req).read()

soup = BeautifulSoup(page)

novel = soup.find_all('title')[0].text.split('_')[0] # 提取小说名

menu = []

all_text = soup.find_all('a',target="_blank") # 提取记载有小说章节名和链接地址的模块

regex=re.compile(ur'\u7b2c.+\u7ae0') # 中文正则匹配第..章,去除不必要的链接

for title in all_text:

if re.findall(regex,title.text):

name = title.text

x = [name,title['href']]

menu.append(x) # 把记载有小说章节名和链接地址的列表插入列表中

return menu,novel

def get_chapter(name,url):

"""Get every chapter in menu"""

html=urllib2.urlopen(url).read()

soup=BeautifulSoup(html)

content=soup.find_all('p') # 提取小说正文

return content[0].text

if __name__=="__main__":

url=raw_input("""Input the main page's url of the novel in ZhuLang\n Then Press Enter to Continue\n""")

if url:

menu,title=get_menu(url)

print title,str(len(menu))+'\n Press Enter To Continue \n' # 输出获取到的小说名和章节数

for i in menu:

chapter=get_chapter(i[0],i[1])

raw_input()

print '\n'+i[0]+'\n'

print chapter

print '\n'

上一篇: Python从2.6平滑升级2.7及安装

下一篇: 用python做ppt服务用于导入图片

- openvpn linux客户端使用

52202

- H3C基本命令大全

52107

- openvpn windows客户端使用

42275

- H3C IRF原理及 配置

39142

- Python exit()函数

33644

- openvpn mac客户端使用

30602

- python全系列官方中文文档

29282

- python 获取网卡实时流量

24261

- 1.常用turtle功能函数

24150

- python 获取Linux和Windows硬件信息

22519

- LangChain 1.0-Agent中间件-实现闭环(批准-编辑-拒绝动作)

78°

- LangChain 1.0-Agent中间件-汇总消息

83°

- LangChain 1.0-Agent中间件-删除消息

88°

- LangChain 1.0-Agent中间件-消息压缩

83°

- LangChain 1.0-Agent中间件-多模型动态选择

154°

- LangChain1.0-Agent-部署/上线(开发人员必备)

315°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

359°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

355°

- LangChain1.0-Agent记忆管理

334°

- LangChain1.0-Agent接入自定义工具与React循环

373°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江