python之urllib使用代理访问网页

发布时间:2017-11-28 21:11:32编辑:Run阅读(5562)

在写爬虫前,先去xicidaili.com上面随便找两个免费的

代码如下

# coding: utf-8

__author__ = 'www.py3study.com'

import urllib.request

import random

url = 'http://www.baidu.com'

iplist = ['222.73.68.144:8090'] #这里是建了一个代理iplist地址池,如果有多个可往里面添加

proxy_support = urllib.request.ProxyHandler({'http':(random.choice(iplist))})

#random.choice(iplist) 随机去地址池去一个代理ip

opener = urllib.request.build_opener(proxy_support)

opener.addheaders =

[('User-Agent','Mozilla/5.0 (Windows NT 6.1; WOW64; rv:50.0) Gecko/20100101 Firefox/50.0')]

#给opener添加一个heraders请求头部

urllib.request.install_opener(opener)

response = urllib.request.urlopen(url)

html = response.read()#.decode('utf-8')

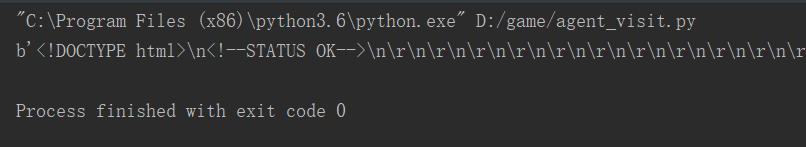

print(html)应该看到的效果

会打印整个页面,这里只是截了一部分

上一篇: python爬虫常用模块

下一篇: python爬虫之 URL的一般格式

- openvpn linux客户端使用

52138

- H3C基本命令大全

52026

- openvpn windows客户端使用

42226

- H3C IRF原理及 配置

39072

- Python exit()函数

33585

- openvpn mac客户端使用

30538

- python全系列官方中文文档

29184

- python 获取网卡实时流量

24198

- 1.常用turtle功能函数

24101

- python 获取Linux和Windows硬件信息

22436

- LangChain1.0-Agent-部署/上线(开发人员必备)

229°

- LangChain1.0-Agent-Spider实战(爬虫函数替代API接口)

261°

- LangChain1.0-Agent(进阶)本地模型+Playwright实现网页自动化操作

274°

- LangChain1.0-Agent记忆管理

259°

- LangChain1.0-Agent接入自定义工具与React循环

291°

- LangChain1.0-Agent开发流程

266°

- LangChain1.0调用vllm本地部署qwen模型

295°

- LangChain-1.0入门实践-搭建流式响应的多轮问答机器人

295°

- LangChain-1.0入门实战-1

299°

- LangChain-1.0教程-(介绍,模型接入)

309°

- 姓名:Run

- 职业:谜

- 邮箱:383697894@qq.com

- 定位:上海 · 松江